Il riconoscimento facciale è una tecnologia di deep learning capace di sfruttare i dati biometrici dei volti per rintracciare l’identità degli individui. Viene applicata ad ambiti molto diversi tra loro: si può trovare nei robot assistenziali, nel marketing, nei sistemi di pagamento elettronico, nel settore della giustizia, ma anche per monitorare gli individui delle specie animali in via di estinzione. In particolare, le forze dell’ordine sempre più spesso implementano i sistemi di facial recognition nelle indagini, ma anche per identificare i volti dei manifestanti.

Il riconoscimento facciale è una tecnologia di deep learning capace di sfruttare i dati biometrici dei volti per rintracciare l’identità degli individui. Viene applicata ad ambiti molto diversi tra loro: si può trovare nei robot assistenziali, nel marketing, nei sistemi di pagamento elettronico, nel settore della giustizia, ma anche per monitorare gli individui delle specie animali in via di estinzione. In particolare, le forze dell’ordine sempre più spesso implementano i sistemi di facial recognition nelle indagini, ma anche per identificare i volti dei manifestanti.

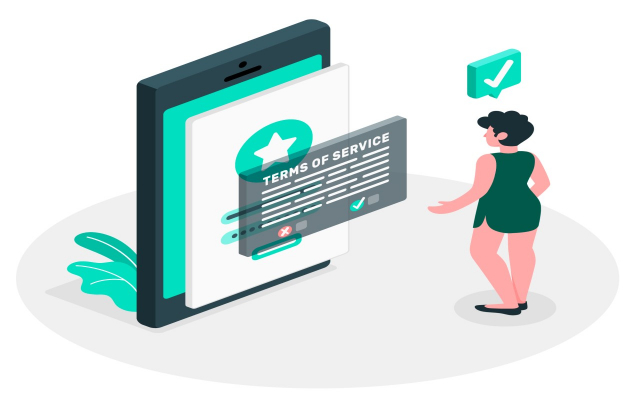

Questo uso sta suscitando perplessità tra l’opinione pubblica, catapultandoci indietro nel tempo, a situazioni ottocentesche o a momenti bui di dittatura durante i quali la verità propagandata doveva essere una e incontestabile. La disponibilità di dati in quantità crescente, di hardware potenti, di procedure statistiche sempre più performanti e di reti neurali raffinate, con nodi nascosti e algoritmi di apprendimento sofisticati, permettono oggi di ottenere risultati strabilianti nel settore dell’Intelligenza Artificiale. Il machine perception, per esempio, è quel settore dell’IA alla base delle tecnologie di riconoscimento facciale, in grado di profilare i soggetti e di identificarli attraverso le caratteristiche visive. Per riuscire a riconoscere i volti delle persone, le reti, per lo più, vengono addestrate con le immagini che noi stessi condividiamo sulla rete. MegaFace e MSCeleb sono i dataset più completi rilasciati da Microsoft e dall’Università di Seattle nel 2016. Contengono milioni di foto estratte direttamente da internet, dai nostri social e da Flickr. Un altro modo per raccogliere e processare le immagini è convincere i soggetti a rilasciarle liberamente, facendo in modo che accettino le condizioni d’uso del contratto. In altri contesti, come per esempio in Cina, per costruire il noto sistema di identificazione collegato agli uiguri (minoranza etnico-religiosa di un distretto cinese) sono state raccolte le immagini di coreani, tibetani e uiguri scattando direttamente foto, ignorando dunque ogni possibile consenso e liberatoria.

Le criticità relative al riconoscimento facciale rientrano in uno dei quesiti più importanti dell’agenda politica internazionale e cioè come rendere l’IA più morale? La sorveglianza è una violazione della sfera privata o è un bene per la comunità? Dipende tutto da vari fattori, innanzitutto contestuali. Se essa è applicata in società che violano i diritti umani come l’Egitto rischierebbe di trasformare il controllo già capillare in una morsa senza uscita. Le schede perforate dell’IBM furono usate per censire gli ebrei, ciò permise al Nazismo di portare a termine la Soluzione Finale con rapidità e precisione. Il Riconoscimento Facciale presenta troppe criticità, servono, dunque, molte più garanzie per impedire che esso diventi alleato di eventuali dittature.

Le criticità relative al riconoscimento facciale rientrano in uno dei quesiti più importanti dell’agenda politica internazionale e cioè come rendere l’IA più morale? La sorveglianza è una violazione della sfera privata o è un bene per la comunità? Dipende tutto da vari fattori, innanzitutto contestuali. Se essa è applicata in società che violano i diritti umani come l’Egitto rischierebbe di trasformare il controllo già capillare in una morsa senza uscita. Le schede perforate dell’IBM furono usate per censire gli ebrei, ciò permise al Nazismo di portare a termine la Soluzione Finale con rapidità e precisione. Il Riconoscimento Facciale presenta troppe criticità, servono, dunque, molte più garanzie per impedire che esso diventi alleato di eventuali dittature.

Innanzitutto lo si può impiegare per “sorvegliare i sorveglianti”, così che nessuno possa conservare per sé, nascosto, il proprio volto, diventando un soggetto anonimo, invisibile per ogni sistema di identificazione e punizione. Rousseau sosteneva che la Volontà, per essere generale, equa e fare, dunque, il bene collettivo, doveva essere un agglomerato di tutti i voleri personali, una Volontà per tutti perché di tutti. Quando un soggetto conservava per sé un diritto, un potere, senza alienarlo in questo comune corpo collettivo, inevitabilmente si generava una disuguaglianza tra i soggetti del patto e la possibilità che quell’uno potesse far valere il proprio potere individuale sugli altri cittadini che avevano invece ceduto i loro. È per questo motivo che i dimostranti nelle proteste stanno cominciando a utilizzare i sistemi di riconoscimento facciale contro gli agenti, “smascherando” l’identità dietro la tenuta antisommossa, così da poter avere un nome da richiamare alla responsabilità. Se si vuole impiegare il riconoscimento facciale nel controllo pubblico nessuno dei cittadini deve mai conservare il proprio volto, altrimenti si genererebbe uno squilibrio di forza e il monopolio del potere della polizia si abbandonerebbe a facili abusi.

Sempre più spesso, inoltre, viene domandato agli scienziati di includere nelle loro ricerche e pubblicazioni scientifiche una sorta di dichiarazione di responsabilità, nella quale offrire indicazioni etiche e possibili impatti che la tecnologia potrebbe avere nel sistema. Nella conferenza NeurIPS (Neural Information Processing Systems) è stato chiesto inviare paper assieme a una dichiarazione di responsabilità sulle possibili preoccupazioni etiche e sui potenziali impatti negativi che le loro tecnologie potrebbero causare nella società. Anche la rivista Nature Machine Intelligence sta sperimentando un approccio simile, domandando agli autori di includere un’analisi etica dei loro lavori[1]. I rapporti tra etica e scienza fanno parte di una questione antica, da una parte si cerca di depurare il momento del test da ogni giudizio di valore, dall’altro si cerca di moralizzare e responsabilizzare il sapere perché il potere non diventi mera liceità senza critica. La scienza chiede ai ricercatori massima attenzione affinché nella fase di scoperta non si inseriscano fattori soggettivi e principi morali. In seguito, però, quando le leggi si trasformano in tecnologia applicata, l’etica diventa una parte preponderante dell’oggetto. L’oggetto fisico si volge in un oggetto sociale: da questione di fatto diventa questione concettuale.

Sempre più spesso, inoltre, viene domandato agli scienziati di includere nelle loro ricerche e pubblicazioni scientifiche una sorta di dichiarazione di responsabilità, nella quale offrire indicazioni etiche e possibili impatti che la tecnologia potrebbe avere nel sistema. Nella conferenza NeurIPS (Neural Information Processing Systems) è stato chiesto inviare paper assieme a una dichiarazione di responsabilità sulle possibili preoccupazioni etiche e sui potenziali impatti negativi che le loro tecnologie potrebbero causare nella società. Anche la rivista Nature Machine Intelligence sta sperimentando un approccio simile, domandando agli autori di includere un’analisi etica dei loro lavori[1]. I rapporti tra etica e scienza fanno parte di una questione antica, da una parte si cerca di depurare il momento del test da ogni giudizio di valore, dall’altro si cerca di moralizzare e responsabilizzare il sapere perché il potere non diventi mera liceità senza critica. La scienza chiede ai ricercatori massima attenzione affinché nella fase di scoperta non si inseriscano fattori soggettivi e principi morali. In seguito, però, quando le leggi si trasformano in tecnologia applicata, l’etica diventa una parte preponderante dell’oggetto. L’oggetto fisico si volge in un oggetto sociale: da questione di fatto diventa questione concettuale.

La Pars Destruens di Bacone, insomma, metteva in guardia dai possibili idoli che, intervenendo nell’osservazione, avrebbero falsato l’esperimento scientifico. In realtà come esplicitò Popper l’osservazione è sempre carica di teoria, non è mai possibile avere un punto di vista completamente puro, svincolato dall’identità e dalla storicità di chi guarda. La prospettiva è inseparabile dai pregiudizi culturali e dalle caratteristiche con cui si sono evoluti i nostri organi di senso. Tutto ciò rende ogni osservazione inevitabilmente fenomenica: gli oggetti sono “come appaiono al soggetto che osserva”. In ogni caso, è bene conoscere i nostri limiti (i pregiudizi) per avere un margine di controllo sulle pre-comprensioni umane. Tuttavia è ancora più fondamentale prestare un’attenzione più puntuale quando gli strumenti tecnologici fuoriescono dal laboratorio, inserendosi nelle maglie sociali. La tecnologia ha sempre un impatto e le sue conseguenze andrebbero analizzate precocemente prima che ogni possibilità diventi un rischio concreto. È per questo che viste le problematiche emerse nell’ambito dell’Intelligenza Artificiale e nel facial recognition in questo caso hanno riportato l’etica al centro della fase più sociologica del positivismo.

Ci si chiede se è legale utilizzare i selfie che postiamo per addestrare le reti neurali. In realtà le norme non sono chiare e unanimi, questo caos si trasforma nel hobbesiano “silenzio della legge”, ultimo scampolo di libertà all’interno della società civile. Da un lato questo silenzio può essere usato dai manifestanti per controllare gli agenti, è vero, dall’altro però il Face Id può continuare a essere applicato indiscriminatamente, senza temere punizioni. Il GDPR europeo prevede che non si possano usare immagini senza il consenso dei proprietari, ma, in mancanza di un caso giudiziario che abbia già giudicato tale possibilità come un reato, resta un’indicazione vaga. Solo nell’Illinois esistono precedenti giudiziari in cui le aziende vengono citate in giudizio per l’uso dei volti umani senza il diretto consenso dei proprietari[2]. Da poco anche a Portland è stata emanata una legge atta a impedire l’uso dell’IA nelle indagini di polizia e per la profilazione dei clienti.

Anche quando le aziende ottenessero il consenso delle persone, potremo essere sicuri che i gruppi socio-economicamente svantaggiati siano realmente consapevoli di cosa stanno acconsentendo? Cosa accadrà quando le reti neurali apprenderanno con data set molto più contenuti? Poche liberatorie saranno necessarie per identificare la maggioranza non consenziente. Sono molte le ricerche aventi l’obiettivo di strutturare algoritmi di apprendimento basati praticamente su nessun dato, “no data”. Insomma, l’idea è far sì che l’IA funzioni come i bambini. Dovrà imparare a riconoscere più dati di quelli su cui è stata addestrata. In Europa la Commissione è incerta sul da farsi. Resta aperto il dubbio se insistere con i finanziamenti alle tecnologie per la sorveglianza negli aeroporti e negli altri punti di scalo. A tal riguardo, iBorderCtrl è un progetto finanziato da Horizon 2020. Esso ha per oggetto l’analisi delle micro-espressioni facciali. L’intenzione è quella di rilevare bugie ed incertezze di coloro che vorrebbero entrare in Europa. Com’è ovvio si tratta di un progetto dalla dubbia eticità, già denunciato da due ricercatori, Daniel Leufer e Fieke Jansen, per le sue possibili conseguenze amorali, per gli abusi che potrebbero perpetuare forme di razzismo. In mancanza di norme certe a riguardo i manifestanti hanno provveduto a tutelarsi seguendo altre vie. Hanno infatti provveduto a diramare l’invito a non registrare video durante le manifestazioni, perché quei filmati di denuncia non diventassero armi contro gli attivisti presenti alla protesta, e soprattutto hanno iniziato a impiegare quegli stessi sistemi di riconoscimento contro gli agenti di polizia da cui stavano ricevendo abusi.

Anche quando le aziende ottenessero il consenso delle persone, potremo essere sicuri che i gruppi socio-economicamente svantaggiati siano realmente consapevoli di cosa stanno acconsentendo? Cosa accadrà quando le reti neurali apprenderanno con data set molto più contenuti? Poche liberatorie saranno necessarie per identificare la maggioranza non consenziente. Sono molte le ricerche aventi l’obiettivo di strutturare algoritmi di apprendimento basati praticamente su nessun dato, “no data”. Insomma, l’idea è far sì che l’IA funzioni come i bambini. Dovrà imparare a riconoscere più dati di quelli su cui è stata addestrata. In Europa la Commissione è incerta sul da farsi. Resta aperto il dubbio se insistere con i finanziamenti alle tecnologie per la sorveglianza negli aeroporti e negli altri punti di scalo. A tal riguardo, iBorderCtrl è un progetto finanziato da Horizon 2020. Esso ha per oggetto l’analisi delle micro-espressioni facciali. L’intenzione è quella di rilevare bugie ed incertezze di coloro che vorrebbero entrare in Europa. Com’è ovvio si tratta di un progetto dalla dubbia eticità, già denunciato da due ricercatori, Daniel Leufer e Fieke Jansen, per le sue possibili conseguenze amorali, per gli abusi che potrebbero perpetuare forme di razzismo. In mancanza di norme certe a riguardo i manifestanti hanno provveduto a tutelarsi seguendo altre vie. Hanno infatti provveduto a diramare l’invito a non registrare video durante le manifestazioni, perché quei filmati di denuncia non diventassero armi contro gli attivisti presenti alla protesta, e soprattutto hanno iniziato a impiegare quegli stessi sistemi di riconoscimento contro gli agenti di polizia da cui stavano ricevendo abusi.

Conclusione

Le tecnologie non sono autosufficienti; in questo ambito non c’è un sistema smithiano che regoli in modo automatico il loro impatto, generando un’identità tra interesse privato e beneficio pubblico. Personalmente dubito che la Mano Invisibile auto-bilanci gli egoismi per il vantaggio di tutti. In realtà, come ogni mano, va sempre in coppia, così da lavarsi le mani più agilmente di fronte alla forbice sociale che il liberismo sfrenato produce. La tecnologia, in ogni caso, ha bisogno di una supervisione umana (contrariamente ai timori luddisti l’innovazione tecnologica non ci ruba il lavoro, ma genera sempre più posti, mestieri qualificati, non meccanici e alienanti), di un animale politico e sociale che fissi le regole per definire un uso etico, prosociale dell’IA. In ogni caso, sarebbe comunque sufficiente avere norme nette per impedire che l’impiego dei dispositivi digitali, come il Facial Recognition, siano una nuova fonte di disuguaglianza. L’IA deve risolvere problemi, non deve crearne di nuovi.

[1]Ibidem.

[2]Cfr. https://www.nature.com/articles/d41586-020-03187-3?utm_source=Nature%20Briefing&utm_campaign=dfed4a7f39-briefing-dy-20201119&utm_medium=email&utm_term=0_c9dfd39373-dfed4a7f39-45459534&fbclid=IwAR0ynz_9VO83VUhyZHmaVHb5s_ylLo6wvDY6UGXDB3mz4BbFMZaxGwVQP10.

Sempre più spesso, inoltre, viene domandato agli scienziati di includere nelle loro ricerche e pubblicazioni scientifiche una sorta di dichiarazione di responsabilità, nella quale offrire indicazioni etiche e possibili impatti che la tecnologia potrebbe avere nel sistema. Nella conferenza NeurIPS (Neural Information Processing Systems) è stato chiesto inviare paper assieme a una dichiarazione di responsabilità sulle possibili preoccupazioni etiche e sui potenziali impatti negativi che le loro tecnologie potrebbero causare nella società. Anche la rivista Nature Machine Intelligence sta sperimentando un approccio simile, domandando agli autori di includere un’analisi etica dei loro lavori

Sempre più spesso, inoltre, viene domandato agli scienziati di includere nelle loro ricerche e pubblicazioni scientifiche una sorta di dichiarazione di responsabilità, nella quale offrire indicazioni etiche e possibili impatti che la tecnologia potrebbe avere nel sistema. Nella conferenza NeurIPS (Neural Information Processing Systems) è stato chiesto inviare paper assieme a una dichiarazione di responsabilità sulle possibili preoccupazioni etiche e sui potenziali impatti negativi che le loro tecnologie potrebbero causare nella società. Anche la rivista Nature Machine Intelligence sta sperimentando un approccio simile, domandando agli autori di includere un’analisi etica dei loro lavori Anche quando le aziende ottenessero il consenso delle persone, potremo essere sicuri che i gruppi socio-economicamente svantaggiati siano realmente consapevoli di cosa stanno acconsentendo? Cosa accadrà quando le reti neurali apprenderanno con data set molto più contenuti? Poche liberatorie saranno necessarie per identificare la maggioranza non consenziente. Sono molte le ricerche aventi l’obiettivo di strutturare algoritmi di apprendimento basati praticamente su nessun dato, “

Anche quando le aziende ottenessero il consenso delle persone, potremo essere sicuri che i gruppi socio-economicamente svantaggiati siano realmente consapevoli di cosa stanno acconsentendo? Cosa accadrà quando le reti neurali apprenderanno con data set molto più contenuti? Poche liberatorie saranno necessarie per identificare la maggioranza non consenziente. Sono molte le ricerche aventi l’obiettivo di strutturare algoritmi di apprendimento basati praticamente su nessun dato, “